0 引言

并联机构运动学标定是提高并联机构精度的经济有效的方法之一,一般包含4个步骤:运动学标定模型建立、末端机构位姿测量、机构参数识别和补偿误差。

末端机构位姿的测量分为两种:一种是利用外部测量仪器如三坐标测量仪、激光跟踪仪等来确定机构位姿[1-5];另一种是利用安装在主动或从动铰链上的内部传感器来检测运动变量。目前比较流行的方法是利用视觉测量机构末端的位姿,以相机位置可以分为相机放置机构末端的手眼视觉和不放在机构上的固定场景视觉。固定场景视觉常用于双目或单目立体视觉当中,通过放置在机构外的视觉设备获得机构末端的三维坐标信息。ZHANG等[6]利用立体视觉,检测机构末端的靶板从而进行标定;RENAUD 等[7]利用摄像机识别机构末端平台的位置姿态;张姝[8]利用图像匹配技术,让双目摄像机直接识别机构末端位置姿态。手眼视觉将摄像机安装在机器人手部末端,在机器人工作过程中随机器人一起运动。李兵等[9]将相机安装在机构末端,通过求解相机模型的外参获得机构末端的关节旋量,进而得到末端位姿;MENDIKUTE等[10]将Optical Measuring Machine安装在机床主轴上进行机床的自标定;PALMIERI等[11]利用手眼视觉,在运动学误差模型的基础上提出了一种基于一阶近似方法的全局标定方法。 VACO等[12]将双目视觉安装在机器人末端,利用立体视觉测量球形靶板以获得机器人末端位置。上述手眼视觉都是摄像机安装在机构末端轴线上,没有涉及特殊机构无法放置在末端轴线上的情况。

VACO等[12]将双目视觉安装在机器人末端,利用立体视觉测量球形靶板以获得机器人末端位置。上述手眼视觉都是摄像机安装在机构末端轴线上,没有涉及特殊机构无法放置在末端轴线上的情况。

由于实验方法的不同,利用手眼视觉进行运动学误差标定的标定方法也有所差异。AGAND等[13]在球面2-DOF并联机构上利用视觉进行运动学标定,将球面运动空间利用公式转化到平面上,再利用相机模型外参获得末端位姿。王晨学等[14]利用双目视觉辅助定位平面,利用平面约束标定法进行标定;刘峰等[15]以四自由度跟踪平台为研究对象,通过摄像机识别自制的靶板,利用针孔模型获得相机外参数得到机构末端的位置姿态。DU 等[16]基于在线标定技术,利用手眼视觉对机构末端进行实时的轨迹误差补偿,以达到提高机构精度的目的;任思旭[17]利用PNP算法建立视觉模型,通过PNP算法获取机构末端的位置姿态;李雷远[18]利用Kinect相机获取图像的深度信息,在此基础上建立视觉模型。

图像特征的识别是视觉应用的前提,利用视觉进行标定一定要识别某个靶板或机构末端零件,图像识别应用最多的就是识别特征角点。熊浩亮[19]对比Sobel算子和Canny算子并利用Sobel算子进行图像分割识别;马瑾等[20]利用ID Maker标记块作为靶板,并应用标记块识别算法得到机构末端位置姿态;LI等[21]利用MATLAB中自带的相机标定程序识别方格特征角点,并获得靶板的位置姿态。

本文提出了一种利用简化的针孔模型与特殊靶板相结合的方案,通过环路增量法的运动学标定模型,实现了机器人的标定。

1 平面机构误差分析及运动学标定

1.1 基于环路增量法建立各个环路误差模型

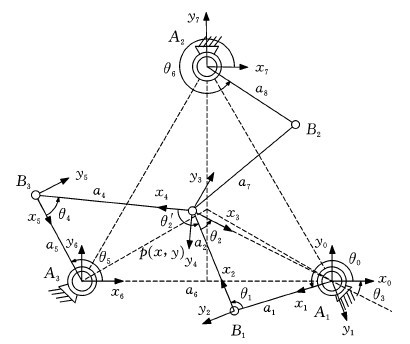

在平面2-DOF冗余驱动并联机器人各个关节处建立坐标系,x轴、y轴如图1所示,z轴垂直于该平面。由于是冗余驱动机构,其末端执行器的位置P由任意两个分支就可以确定,第三个分支可以随动或施加力矩驱动,所以在建立机构的几何误差模型时只需考虑用于位置控制的两个分支。此处选择第1、3分支作为位置控制分支,利用环路增量法建立机构的误差模型。

图1 机构误差参数模型

Fig.1 Error parameter model of mechanism

用dai(i=1,2,…,6)表示机构的连杆参数误差,用dθi(i=1,2,…,6)表示关节转角误差,用ddi(i=1,2,…,6)表示机构连杆间偏置误差,dαi(i=1,2,…,6)表示关节轴线垂直度。由于机构为平面机构,选择加工精度高的机床可以保证关节z轴基本垂直于水平面,故在D-H参数中认为ddi、dαi都为0。

按照环路选取原则[22],选取以下两条环路:

环路Ⅰ由A1-B1-P-A1组成,所涉及到的坐标系为0-1-2-3。

环路Ⅱ由A1-B1-P-B3-A3-A1组成,所涉及到的坐标系为0-1-2-4-5-6。

环路Ⅰ的齐次变换矩阵为

(1)

环路Ⅱ的齐次变换矩阵为

(2)

其中,![]() 为利用D-H参数的相邻连杆坐标系之间的变换矩阵。

为利用D-H参数的相邻连杆坐标系之间的变换矩阵。

分别将式(1)、式(2)对时间微分,得

![]()

![]()

(3)

(4)

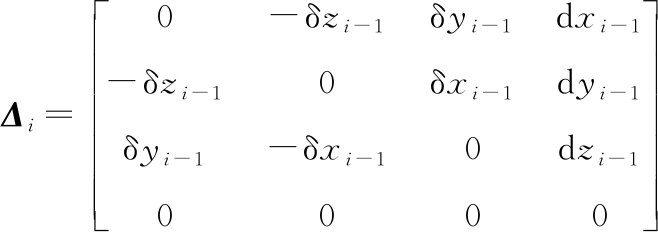

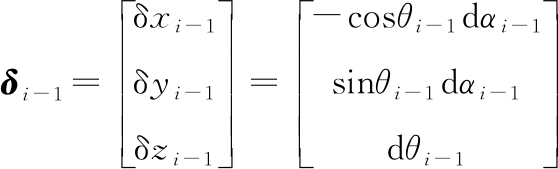

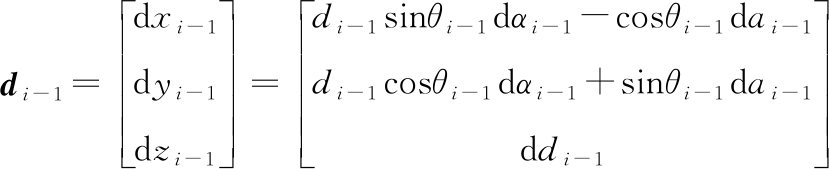

其中,Δi为连杆在i系中的位姿误差[23],具体表达式为

(5)

其中,i=1,2,…,7,式(4)中最后一个Δ0与Δ7取值相同,这里用Δ0代替Δ7。

对于式(5),定义:

(6)

(7)

式(3)、式(4)中各项对应元素之和为零,分别等价于下列矢量方程:

(8)

(9)

1.2 机构误差模型建立

已知原始误差源为:驱动关节运动参量误差dθ0、dθ5,连杆参数误差dai(i=1,2,…,6);5个未知误差为:从动关节运动量参数误差dθ1、dθ2、dθ′2、dθ3、dθ7。

将式(8)、式(9)分别相加,得到

(10)

由式(10)可知只有2个独立方程。

根据冗余机构特点z3和z4重合,则存在以下关系:

(11)

式(11)有3个独立方程,式(10)有2个方程,联立可以解出5个未知量。综上,建立了平面2-DOF冗余驱动并联机器人误差模型。

1.3 机构末端误差模型建立

P点作为输出,固连在连杆l3-2上,位于3系上,d3、δ3分别为该杆相对于自身坐标系的微分平动和微分转动,该连杆在3系中的原始误差和在基坐标系中的位姿误差关系为

(12)

其中,Δ为连杆l3-2在基坐标系中的位姿误差,即

(13)

其中,0δ3为连杆l3-2的微分转动,即为0;0d3为相对于基坐标系的微分平动,对应于末端执行器的位置误差。

1.4 平面2-DOF冗余驱动并联机器人运动学标定

平面2-DOF冗余驱动并联机构通过两个驱动分支就能够确定机构末端的位置,上文已经得到以1、3分支作为位置控制分支的误差模型。为了辨识并标定出第二分支的误差参数,以1、2分支作为位置控制分支再建立一个误差模型,误差模型与上文同理。采用D-H参数,基于环路增量法构建平面2-DOF冗余并联机构理论误差模型。将式(13)最后一列展开并忽略z方向分量,以1、3分支和1、2分支分别作为位置控制建立误差模型,得到

(14)

其中,dX为末端执行器在检测位置时测量值与理论值之间的偏差矩阵,dXi=[dxidyi]T;Wi(i=1,2)为该检测位置的参数识别矩阵;dUi(i=1,2)为位置误差的参数识别矩阵:

(15)

式(15)中包含了全部误差源,dx1、dy1,dx2、dy2,dx3、dy3为A1,A2,A3三点位置误差, dθ0,dθ5,dθ6为关节转角误差。

对于驱动误差(关节转角误差)通过控制器保证,在标定实验中作为已知量直接给出。对于A1,A2,A3三点位置误差,在加工时予以保证。则标定模型可简化为

(16)

(17)

其中,dX′i(i=1,2)为标定模型简化后末端执行器在检测位置时测量值与理论值之间的偏差矩阵;W′i(i=1,2)为标定模型简化后测量位置的参数识别矩阵;dU′i(i=1,2)为标定模型简化后位置误差的参数识别矩阵。

式(16)即为该机构最终标定模型,需要利用最小二乘法进行求解,只要保证W′非奇异,标定就可以顺利完成。

2 单目视觉标定方法研究

2.1 工业相机标定

为了保证标定数据准确,减少后续位置计算的计算量,首先对摄像机内部参数进行标定,标定采用针孔模型和畸变模型,利用张正友法[24]进行标定。待标定的内部参数主要包括有效焦距、一阶透镜径向畸变系数和比例因子。

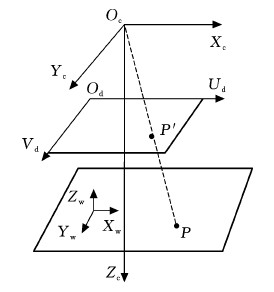

普通的针孔模型如图2所示。图中OcXcYcZc为相机坐标系,OdUdVd为像素坐标系,XwYwZw为世界坐标系,P′点为成像点,P点为现实中采集的点。

图2 针孔成像模型

Fig.2 Pinhole imaging model

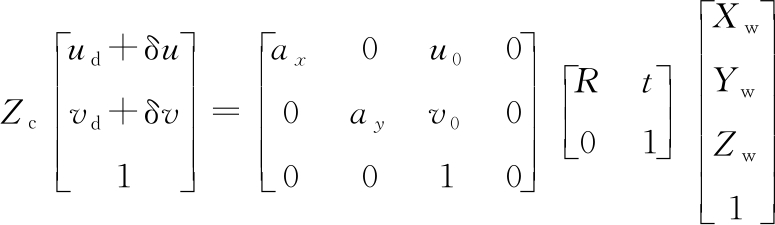

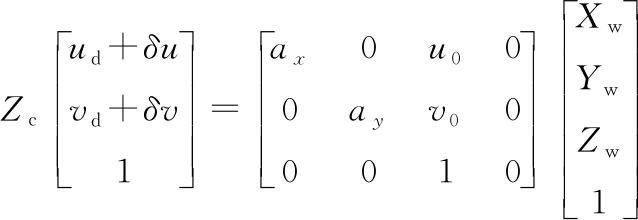

通过考虑畸变,利用图2的针孔模型建立相机模型:

(18)

其中,非线性畸变量δu=ΔUd(k1r2+k2r4)、δv=ΔVd(k1r2+k2r4),ΔUd、ΔVd为成像点与图像中心的偏差值,k1、k2为畸变系数,r为成像点与图像中心的距离;ud、vd为像素坐标系坐标;ax、ay为有效焦距;u0、v0为相面中心位置;Zc为物距;[Xw Yw Zw]T为世界坐标系坐标矩阵; 为相机内参矩阵;

为相机内参矩阵;![]() 为相机外参矩阵。

为相机外参矩阵。

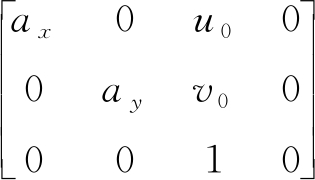

通过检测若干如图3所示黑色方块的四个顶点(即特征角点),将多组相邻角点的像素坐标和实际坐标代入式(18)中,求出相机的内参数以及畸变系数,结果如表1所示。

图3 相机标定板

Fig.3 Camera calibration board

表1 相机内部参数

Tab.1 Camera internal parameters

ax1 600.91ay1 593.93k1-0.07k2-0.21

2.2 相机模型简化及视觉标定的误差计算

首先设计了一个用于标定实验的靶板,如图4所示。由于实验时机构末端的轨迹为一个直径160 mm的圆,所以将12个检测中心均匀分布在这个圆上,并且将圆心也作为一个检测中心。在这13个检测中心处作等腰三角形,等腰三角形的中心为检测中心,并且要求三角形竖直放置。

图4 标定实验靶标

Fig.4 Calibration of experimental targets

为了适应靶板的特殊样式和简化后的针孔模型,本文提出的方法要求相机不能产生相对机构末端执行器的位移和转动。由此,相机外参矩阵

![]() 可以看成单位矩阵,简化式(18)得到像素坐标系与世界坐标系转化公式:

可以看成单位矩阵,简化式(18)得到像素坐标系与世界坐标系转化公式:

(19)

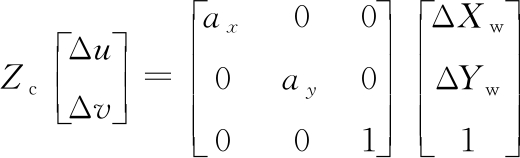

由于标定实验在平面机构上进行,可以将式(19)简化为平面下的针孔模型:

(20)

其中,Δu、Δv为像素坐标系坐标差值;ΔXw、ΔYw为世界坐标系坐标插值,即真实的位置误差。

误差计算的流程如下。首先在图4所示的自制靶标上识别每一个检测点中心并记录其坐标(uk,vk)T,其中k=0,1,…,12。将机构末端原点的像素坐标系坐标(u0,v0)T与识别出的检测点的像素坐标系坐标(uk,vk)T(k=1,2,…,12)相减得到Δuk、Δvk(k=1,2,…,12),再通过式(20)将像素坐标系下的误差转化为世界坐标系下的误差ΔXwk、ΔYwk(k=1,2,…,12),即可以得到视觉标定的真实误差。

2.3 视觉标定的图像分割及识别算法

图像分割是为了方便计算机理解图像而进行的一种图像区域分离处理,目的是将图像中符合需求的部分(目标区域)保留,而将与应用或研究无关的部分(背景区域)去掉。视觉标定图像分割是为了将检测点在图像中的区域与背景分离,为检测点的颜色与形状特征提取做好铺垫。

本文使用最大类间方差法[25]进行图像分割。此方法原理是按图像的灰度特性,找到一个灰度阈值,将图像按灰度值分为背景和目标两类,当这两类间的灰度值方差最大,说明两部分差别最大,错分概率最小。图5即为实验过程中分割处理后的结果,可以看出分割效果理想。

图5 最大类间方差分割图像结果

Fig.5 Image segmentation results based on maximum interclass variance

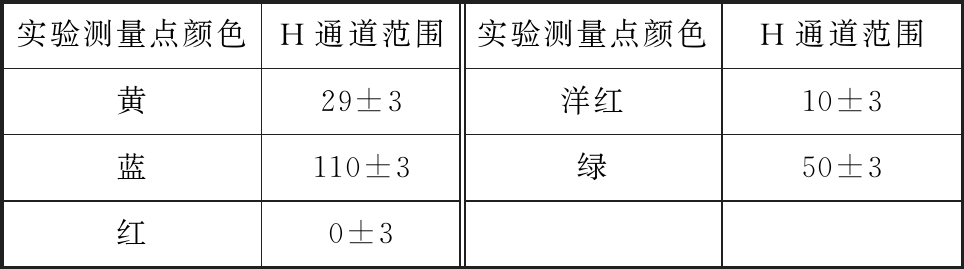

从图5中可以看出,由于实验时相机视野里会出现不止一个测量点,所以需要确定当前状态下要测量的一个测量点。本文利用HSV颜色空间的H通道来识别测量点颜色,用于识别当前需要测量的测量点:

(21)

式(21)为彩色图像数据从RGB色彩空间到HSV色彩空间[26]的转换关系。通过查询实验中所选颜色的RGB值,将RGB值代入式(21)即可得到HSV颜色空间的H通道值。为了考虑色差,在原H通道值上添加±3的误差,形成H通道范围,具体的H通道范围如表2所示。

表2 颜色及其HSV颜色空间H通道范围

Tab.2 Color and its H-channel range in HSV color space

实验测量点颜色H通道范围实验测量点颜色H通道范围黄29±3蓝110±3红0±3洋红10±3绿50±3

2.4 视觉标定的相机转角补偿

由于机构的参数和相机最小物距的限制,导致相机垂直放置时相机中心无法放置在机构末端,此方法将相机偏置放置,但相机会随机构移动而产生旋转。虽然通过机构运动学可以求解此旋转,但机构的旋转有误差,不能直接用运动学求解旋转角。为解决此问题,本文提出一种方法,可以直接识别相机的旋转角度,避开机构精度不高的缺陷。利用识别出的旋转角度可以对图像进行逆旋转,消除相机的旋转对采集图像的影响。再通过2.2节中的误差计算方法得到机构末端的真实误差。

本文采用一种基于边界曲线识别特征角点的方法,通过确定角点的位置判断旋转角度。

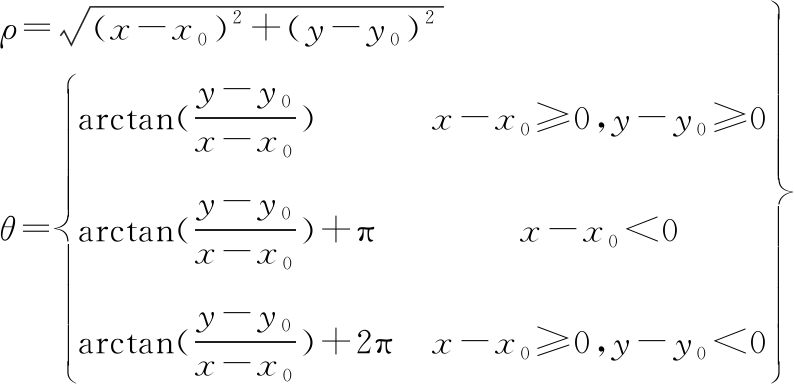

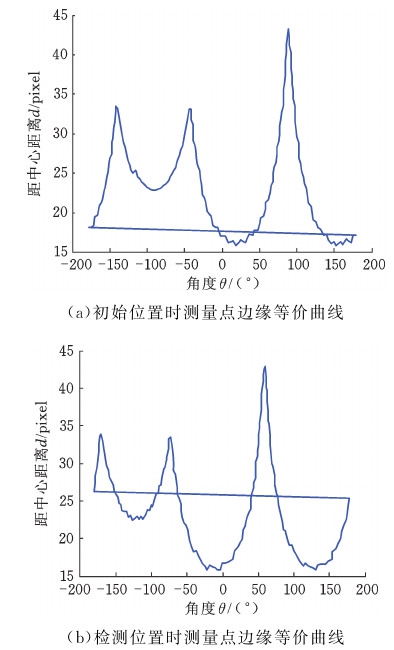

通常情况下,检测点边界上的点用笛卡儿坐标(x,y)表示。由于检测点边缘是封闭的,所以极坐标(θ,ρ)可以代替笛卡儿坐标表示。设检测点的中心为坐标原点,记为(x0,y0),建立极坐标系。在极坐标系下形状边缘表示为如下曲线:

(22)

本文将笛卡儿坐标系下的形状边缘转化为极坐标系下的一组曲线,并利用该曲线找到角点。具体来说,在极坐标系下,圆形的边缘曲线为直线,等腰三角形的边缘曲线存在两个峰值较小的波峰和一个峰值较大的波峰。当等腰三角形发生旋转时,其边缘曲线将平移一定的距离,如图6所示。图像中最高点的x坐标即为此时检测点形状的角度,将测量点与初始位置的x坐标值相减,即为相机的旋转角度。

图6 检测点边缘等价曲线

Fig.6 Edge equivalent curve of eetection point

3 单目视觉标定精度验证

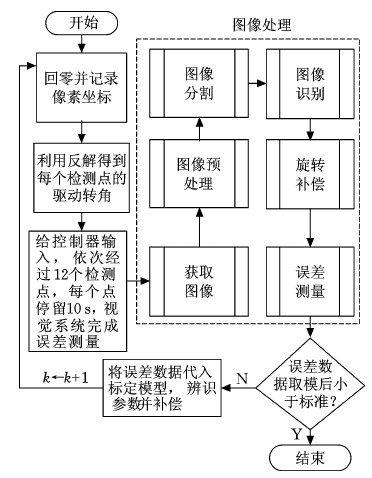

3.1 标定实验步骤

单目视觉标定实验流程如图7所示。平面2-DOF冗余驱动并联机器人末端轨迹为先从圆心沿x轴移动80 mm,再绕直径为160 mm的圆形画圆,随后再沿x轴负方向回零。在圆形轨迹中平均选取12个检测点,在经过12个点时停留并计算误差。

图7 标定实验步骤

Fig.7 Calibration experiment steps

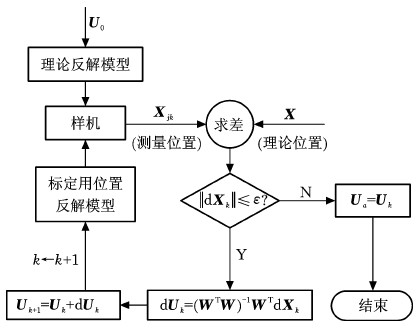

3.2 参数识别及误差补偿流程

参数识别及误差补偿流程如下(图8)。

图8 运动学参数识别及误差补偿流程图

Fig.8 Flow chart of kinematics parameter identification and error compensation

(1)令迭代次数k=0,将机构的原始结构参数U0代入Uk中。

(2)将Uk代入机构运动学反解模型。当k>0时,Uk为修正后的结构参数。将修正后的位置反解作为机构的输入,控制样机进行运动,并用视觉系统检测末端执行器在每个检测点的位置矩阵Xjk,j为测量位置点序号(j=1,2,…,12)。

(3)用实际位置和理论位置做差求出末端执行器位置误差dXjk,即(ΔXw,ΔYw)T。得到12组数据,组成原始误差矩阵dXk。

(4)给末端执行器的位置误差矩阵dXk取模得到![]() 利用该数值作为迭代停止条件。取适当的正数ε,当

利用该数值作为迭代停止条件。取适当的正数ε,当![]() 时迭代结束,此时的结构参数矩阵Uk中的参数即为机构的实际结构参数;若

时迭代结束,此时的结构参数矩阵Uk中的参数即为机构的实际结构参数;若![]() 则进行下一次迭代。

则进行下一次迭代。

(5)计算dUk=(WTW)-1WTdXk,其中,W为参数辨识矩阵。

(6)对Uk进行结构参数补偿,迭代次数加1,转至(2)继续执行程序,直到满足![]() 为止。

为止。

3.3 利用力/位混合控制策略的控制流程

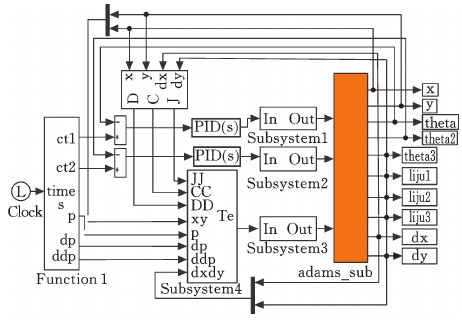

本文采用基于力/位混合的冗余PID控制方案与控制样机进行实验验证,对于平面2-DOF冗余驱动并联机器人来说,其中1、3两个分支采用各关节独立的PID控制,驱动输入为两个分支的理论角位置,来保证位置精度;冗余分支输入为通过基于计算力矩计算出的驱动力。

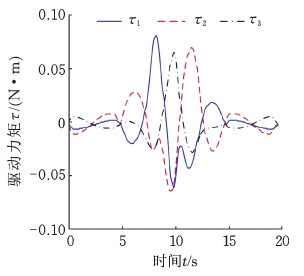

图9和图10为基于力/位混合的冗余控制框图和仿真模型。利用此仿真模型,模拟出实验轨迹下各电机的驱动力矩曲线,如图11所示。只需给2号电机输入相应的驱动力矩曲线,1、3号电机输入转角曲线,即可实现力/位混合控制。

图9 基于力/位混合的冗余控制框图

Fig.9 Redundant control block diagram based on force-position hybrid

图10 基于力/位混合的冗余控制仿真模型

Fig.10 Redundant control simulation model

based on force-position hybrid

图11 伺服电机的驱动力矩

Fig.11 Driving torque of servo motor

3.4 参数识别及误差补偿实验和结果

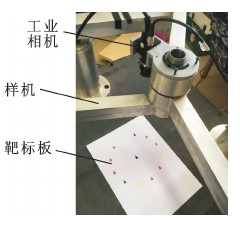

将相机固定在机构末端,标定靶标中心固定在加工时给定的机构中心,垂直于z轴放置。如图12所示。

图12 相机及靶标位置

Fig.12 Camera and target position

实验采用维视MV-EM120C CCD摄像机,分辨率为1 280像素×1 024像素,像元大小为3.75 μm×3.75 μm,靶标板采用CAD软件绘制并打印。

试验流程如图8所示,机构末端从中心点向x轴方向移动80 mm,再按照直径160 mm的圆轨迹运动,依次经过靶标上的12个检测点,在检测点停留10 s进行图像采集和误差运算。

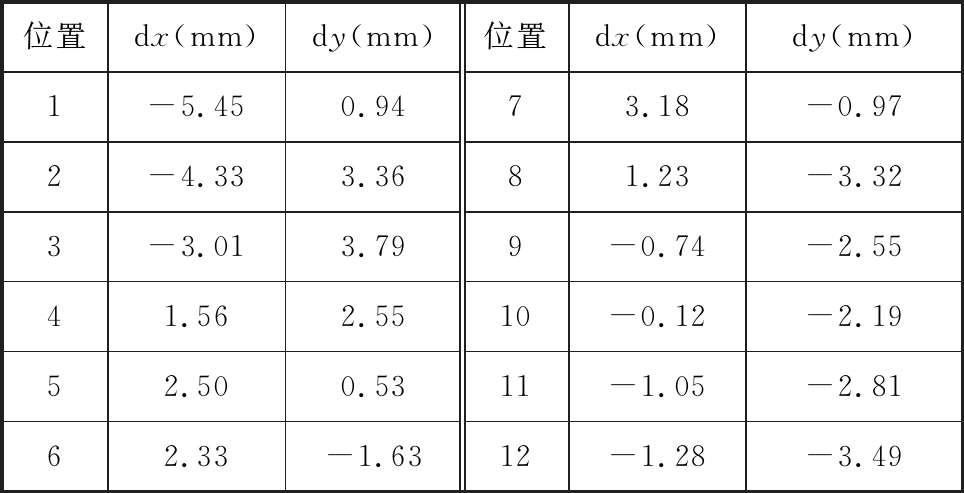

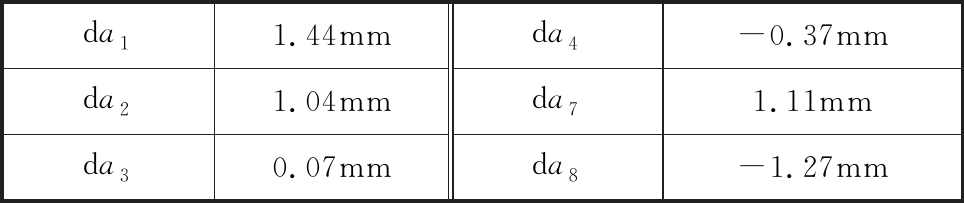

记录机构未标定前的误差值,如表3所示。经过4次标定以后,参数辨识的结果如表4所示,标定后的误差值如表5所示。

表3 标定前机构误差(本文方法)

Tab.3 Mechanism error before calibration(the method in this paper)

位置dx(mm)dy(mm)位置dx(mm)dy(mm)1-5.450.9473.18-0.972-4.333.3681.23-3.323-3.013.799-0.74-2.5541.562.5510-0.12-2.1952.500.5311-1.05-2.8162.33-1.6312-1.28-3.49

表4 标定参数辨识结果(本文方法)

Tab.4 Identification results of calibration parameters(the method in this paper)

da11.44mmda21.04mmda30.07mmda4-0.37mmda71.11mmda8-1.27mm

表5 标定后机构误差(本文方法)

Tab.5 Mechanism error after calibration(the method in this paper)

位置dx(mm)dy(mm)位置dx(mm)dy(mm)11.500.247-0.541.0821.220.8981.23-0.323-0.79-1.299-0.941.0840.560.5510-0.12-0.195-0.580.23110.651.2860.33-1.2312-1.28-0.49

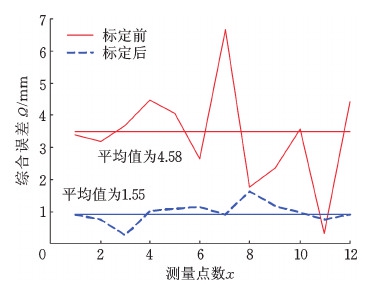

为了评价运动学标定效果,定义综合误差值

(23)

作为误差评价指标,根据表4、表5中相关数据,可以得到标定前后机构末端运动学位置综合误差,如图13所示。从图13中可以看出,标定后并联机构的位置精度得到了明显的提高,标定前位置精度平均误差为4.58 mm,标定后位置精度平均误差为1.55 mm,误差减小为原来的1/3。

图13 标定前后位置综合误差

Fig.13 Comprehensive error of position before and after calibration

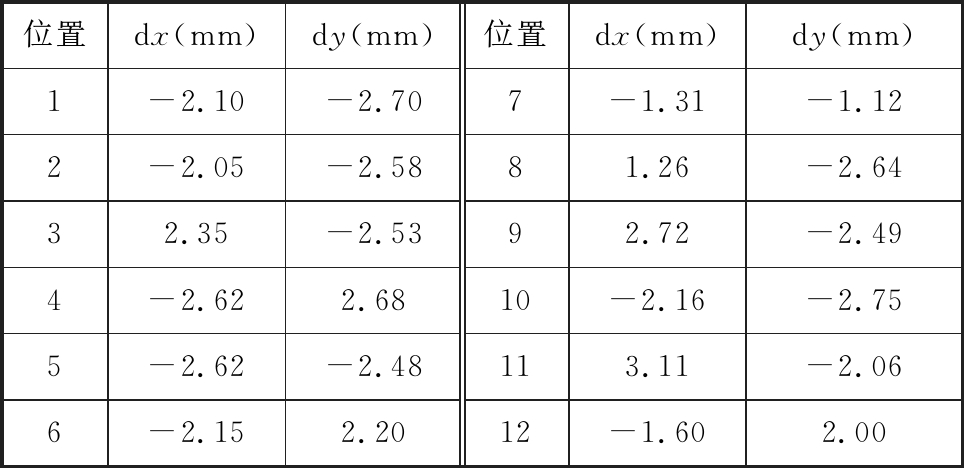

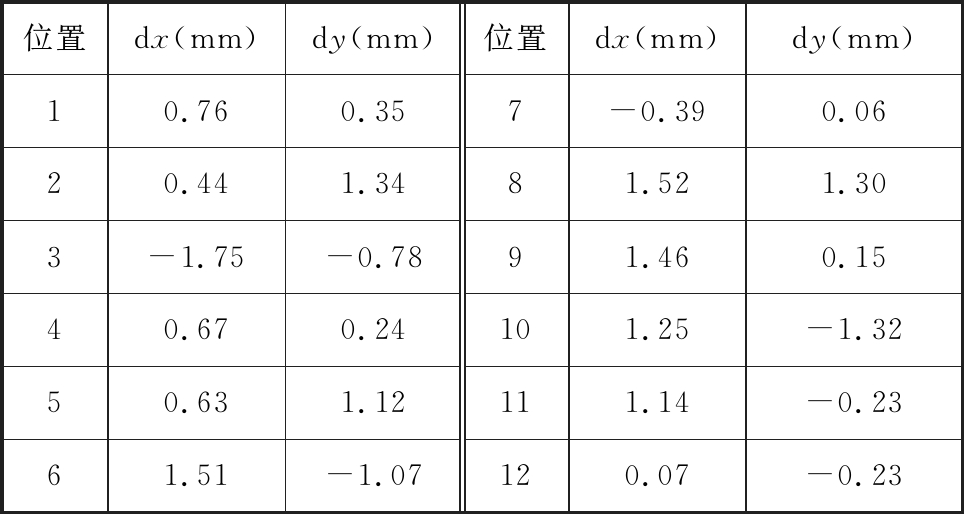

本文为了验证视觉标定方法的优越性,利用传统标定方法再次对机构进行标定,标定实验现场如图14所示。传统标定方法基于矢量法建立机构误差模型,并利用激光跟踪仪对样机进行标定。经过5次标定,标定前后结果如表6、表7所示,标定参数辨识结果如表8所示。

图14 传统标定方法实验现场

Fig.14 Experimental site of traditional calibration method

表6 标定前机构误差(传统方法)

Tab.6 Mechanism error before calibration(traditional method)

位置dx(mm)dy(mm)位置dx(mm)dy(mm)1-2.10-2.707-1.31-1.122-2.05-2.5881.26-2.6432.35-2.5392.72-2.494-2.622.6810-2.16-2.755-2.62-2.48113.11-2.066-2.152.2012-1.602.00

表7 标定后机构误差(传统方法)

Tab.7 Mechanism error after calibration(traditional method)

位置dx(mm)dy(mm)位置dx(mm)dy(mm)10.760.357-0.390.0620.441.3481.521.303-1.75-0.7891.460.1540.670.24101.25-1.3250.631.12111.14-0.2361.51-1.07120.07-0.23

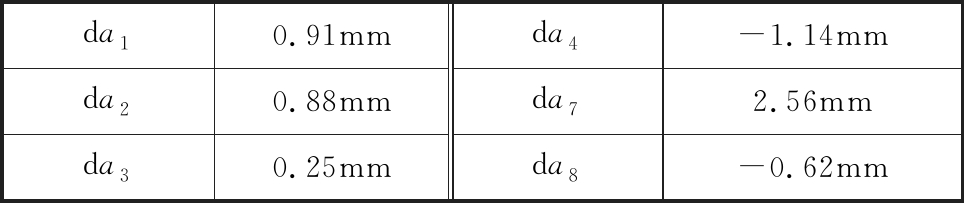

表8 标定参数辨识结果(传统方法)

Tab.8 Identification results of calibration parameters(traditional method)

da10.91mmda20.88mmda30.25mmda4-1.14mmda72.56mmda8-0.62mm

利用式(23),计算出传统方法的标定前后机构末端运动学位置综合误差。标定前平均值为4.52 mm,标定后平均值为1.64 mm。

通过对比两种方法的标定结果可以看出,本文采用的视觉标定方法在标定精度上略胜于传统方法,并且由于本文实验用的相机像素偏小,相机参数制约了机构的精度,如果换成高像素的相机则可以再次提高机构的精度。

4 结论

(1)本文提出了一种基于特征角点确定检测点旋转角度的方法,解决了相机发生偏心旋转的问题,使本文提出的并联机器人运动学标定方法具有一定的普适性。

(2)在能够补偿相机旋转角度的基础上,简化了相机的针孔模型,减少了实验步骤及坐标计算的计算量,使标定实验过程简单、快捷。

(3)基于D-H参数,利用环路增量法,建立了平面2-DOF冗余驱动并联机器人的误差和标定模型;经过4次标定,机构误差减小为原来的1/3,证明了该方法的有效性。本文研究结果为并联机器人标定研究提供了一种标定过程用时短、处理数据量小、实验成本低的标定方法。

[1] 李玉昆,李永泉,佘亚中,等.3-UPS/S并联稳定平台满载工况误差分析与运动学标定[J].中国机械工程,2017,28(8):958-965.

LI Yukun, LI Yongquan, SHE Yazhong, et al. 3-UPS/S Parallel Stable Platform Full Load Condition Error Analysis and Kinematic Calibration[J]. China Mechanical Engineering, 2017,28 (8): 958-965.

[2] 张宪民,曾磊.考虑减速机背隙的3-RRR并联机构的运动学标定[J].华南理工大学学报(自然科学版),2016,44(7):47-54.

ZHANG Xianmin, ZENG Lei. Kinematic Calibration of 3-RRR Parallel Mechanism Considering Backlash of Reducer[J]. Journal of South China University of Technology (Natural Science Edition), 2016,44(7): 47-54.

[3] 樊锐,李茜,王丹.6PUS并联机构的运动学整机标定[J].北京航空航天大学学报,2016,42(5):871-877.

FAN Rui, LI Qian, WANG Dan.6PUS Parallel Mechanism Kinematics Calibration[J]. Journal of Beihang University, 2016,42 (5): 871-877.

[4] HU Y, GAO F, ZHAO X C, et al. Kinematic Calibration of a 6-DOF Parallel Manipulator Based on Identifiable Parameters Separation (IPS)[J]. Mechanism and Machine Theory, 2018, 126: 61-78.

[5] KONG L Y, CHEN G L, ZHANG A, et al. Kinematic Calibration and Investigation of the Influence of Universal Joint Errors on Accuracy Improvement for a 3-DOF Parallel Manipulator[J]. Robotics and Computer-Integrated Manufacturing, 2018, 49:388-397.

[6] ZHANG X, SONG Y, YANG Y, et al. Stereo Vision Based Autonomous Robot Calibration[J]. Robotics and Autonomous Systems, 2017,93: 43-51.

[7] RENAUD P, ANDREFF N, GOGU G, et al. On Vision-based Kinematic Calibration of N-leg Parallel Mechanisms[C]∥IFAC Proceedings Volumes. Rotterdam, 2003:945-950.

[8] 张姝. 基于双目视觉的并联机构末端位姿检测研究[D].镇江:江苏大学,2016.

ZHANG Shu. Research on End Position Detection of Parallel Mechanism Based on Binocular Vision[D].Zhenjiang:Jiangsu University,2016.

[9] 李兵,傅卫平,王雯,等.一种基于EIH的装配机器人标定方法[J].机械工程学报,2018,54(7):38-44.

LI Bing, FU Weiping, WANG Wen, et al. A Calibration Method of Assembly Robot Based on EIH[J]. Journal of Mechanical Engineering, 2018,54 (7): 38-44.

[10] MENDIKUTE A, LEIZEA I, YAGÜE-FABRA J A, et al. Self-calibration Technique for On-machine Spindle-mounted Vision Systems[J]. Measurement, 2018, 113:71-81.

[11] PALMIERI G, PALPACELLI M C, CARBONARI L, et al. Vision-based Kinematic Calibration of a Small-scale Spherical Parallel Kinematic Machine[J]. Robotics and Computer-Integrated Manufacturing, 2018, 49:162-169.

[12]  VACO M,

VACO M,  EKORANJA B,

EKORANJA B,  ULIGOJ F, et al. Calibration of an Industrial Robot Using a Stereo Vision System[J]. Procedia Engineering, 2014,69:459-463.

ULIGOJ F, et al. Calibration of an Industrial Robot Using a Stereo Vision System[J]. Procedia Engineering, 2014,69:459-463.

[13] AGAND P, TAGHIRAD H D, MOLAEE A. Vision-based Kinematic Calibration of Spherical Robots[C]∥RSI International Conference on Robotics and Mechatronics. Tehran, 2015:395-400.

[14] 王晨学,平雪良,徐超.基于视觉辅助定位的机械臂运动学参数辨识研究[J].工程设计学报,2018,25(1):27-34.

WANG Chenxue, PING Xueliang, XU Chao. Study on Kinematics Parameter Identification of Manipulator Based on Visual Aided Positioning[J]. Journal of Engineering Design,2018,25(1):27-34.

[15] 刘峰,王向军,许薇,等.并联跟踪台单目视觉标定方法[J].红外与激光工程,2009,38(1):175-179.

LIU Feng, WANG Xiangjun, XU Wei, et al. Monocular Vision Self Calibration Method for Parallel Tracking Platform[J]. Infrared and Laser Engineering, 2009,38 (1): 175-179.

[16] DU G L, ZHANG P. Online Robot Calibration Based on Vision Measurement[J]. Robotics and Computer-Integrated Manufacturing, 2013, 29(6):484-492.

[17] 任思旭. 基于视觉的并联机器人运动学标定及位姿跟踪方法研究[D]. 哈尔滨:哈尔滨工程大学,2017.

REN Sixu. Research on Kinematics Calibration and Pose Tracking Method of Parallel-based Robot Based on Vision[D].Harbin: Harbin Engineering University, 2017.

[18] 李雷远. 具有视觉伺服的执行机构自主定位与精准控制研究[D].北京: 北京邮电大学,2017.

LI Leiyuan. Research on Autonomous Positioning and Precision Control of Actuator with Visual Servo[D].Beijing: Beijing University of Posts and

Telecommunications, 2017.

[19] 熊浩亮. 基于视觉的三轴SCARA机械手运动学标定研究[D].杭州:浙江大学,2017.

XIONG Haoliang. Vision-based Calibration of Three-axis SCARA Manipulator Kinematics[D]. Hangzhou:Zhejiang University, 2017.

[20] 马瑾,张国峰,戴树岭,等.基于相对视觉位姿的Stewart平台运动学标定[J].系统仿真学报,2016,28(9):2267-2274.

MA Jin, ZHANG Guofeng, DAI Shuling, et al. Stewart Platform Kinematics Calibration Based on Relative Visual Pose[J]. Journal of system simulation,2016,28(9):2267-2274.

[21] LI H, ZHANG X, ZENG L, et al. Vision-aided Online Kinematic Calibration of a Planar 3RRR Manipulator[M]∥Mechanism and Machine Science. Singapore:Springer, 2017:309-313.

[22] 张立杰,李永泉.球面2-DOF冗余驱动并联机器人机构误差分析[J].机械工程学报,2013,49(7):148-154.

ZHANG Lijie, LI Yongquan. Error Analysis of Spherical 2-DOF Redundant Actuated Parallel Robot Mechanism[J]. Journal of Mechanical Engineering, 2013,49(7):148-154.

[23] 石则昌,刘深厚.机构精确度[M].北京:高等教育出版社,1995:189-190.

SHI Zechang, LIU Shenhou. Organization Accuracy[M]. Beijing:Higher Education Press, 1995:189-190.

[24] ZHANG Z. A Flexible New Technique for Camera Calibration[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11):1330-1334.

[25] 曹茂永.数字图像处理[M].北京:高等教育出版社, 2016:56-60.

CAO Maoyong. Digital Image Processing[M]. Beijing:Higher Education Press, 2016:56-60.

[26] 周品,李晓东.MATLAB数字图像处理[M].北京:清华大学出版社, 2012:50-51.

ZHOU Pin, LI Xiaodong. MATLAB Digital Image Processing[M]. Beijing:Tsinghua University Press, 2012:50-51.